背景

最近使用linux系统module模块安装中,使用root用户,执行以下高危命令后

chown -R sysop:sysop /share/apps/repos

yum remove environment-modules.x86_64

导致lsf系统无法启动,xcat无法通信等,折腾了几次perl模块,xcat通信正常后。

lsf系统还是异常

lsload显示节点正常启动,但是bhosts/bjobs依然提示lsf is down,please wait

解决方案

1 通过查询ibm公司排错流程

[https://www.ibm.com/docs/zh/spectrum-lsf/10.1.0?topic=problems-solving-common-lsf](https://www.ibm.com/docs/zh/spectrum-lsf/10.1.0?topic=problems-solving-common-lsf)

找到mbatchd日志文件

tail -fn 100 /share/apps/lsf/log/mbatchd.log.mgt |head

输出以下内容

Feb 29 19:33:21 2024 240794 3 9.1.3 init_log: Log directory </share/apps/lsf/work/cluster1/logdir> not owned by LSF administrator <lsfadmin/1000> (owner ID is 0)

可以看出日志报错,lsf目录权限不为lsfadmin所有,因为背景中提到我给了sysop,后续排错中,我又给了root。基本找到原因了。

2 下面在ibm官网确认这个事情的解决方案

[https://www.ibm.com/docs/zh/spectrum-lsf/10.1.0?topic=overview-important-directories-configuration-files](https://www.ibm.com/docs/zh/spectrum-lsf/10.1.0?topic=overview-important-directories-configuration-files)

以上链接展示了

conf work log的权限应该是lsfadmin的。

下面将权限移交回lsfadmin,并重新启动lsf。

chown -R lsfadmin:lsfadmin /share/apps/lsf/log

chown -R lsfadmin:lsfadmin /share/apps/lsf/work

chown -R lsfadmin:lsfadmin /share/apps/lsf/conf

lsf_daemons restart

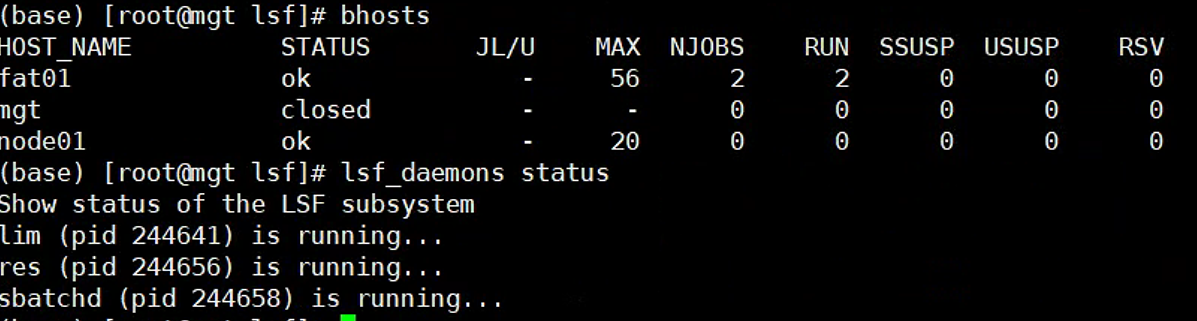

3 检查lsf状态

)

妥善解决

后记

当我们使用root时一切要小心,要记录执行的命令,出问题好排查。

能不使用就不使用。 |  |Archiver|手机版|小黑屋|bioinfoer

( 萌ICP备20244422号 )

|Archiver|手机版|小黑屋|bioinfoer

( 萌ICP备20244422号 )